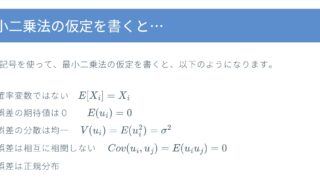

BLUEとは、最良線形不偏推定量(best linear unbiased estimator; BLUE)のことを表します。とても良い推定量ということで、最小二乗法はさまざまな仮定を満たせばBLUEになります。

ここでは以下の式の係数$\beta$の推定量に関して、最小二乗法がBLUEになることを説明します。

$Y_i=\alpha+\beta X_i $

結論は以下の通りです。

線形推定量

最小二乗法の推定値$\hat{\beta}$は$Y_i$の線形関数(加重和)になっているので、線形推定量です。

$\hat\beta= \dfrac {\sum\limits_{i=1}^n (X_i-\bar{X})Y_i}{ \sum\limits_{i=1}^n(X_i-\bar{X})^2}$

線形不偏線形推定量

最小二乗法の推定量$\hat{\beta}$の期待値はβなので、βは線形不偏推定量です。不偏性の条件を満たしています。

最良線形不偏推定量

一般的な線形不偏推定量の式から、分散を計算し、「一般的な線形不偏推定量の分散は、最小二乗法の分散にマイナスではない分散を加えたもの」という形なることを導きだし、最小二乗法の推定量の分散が最小であることを証明します。

線形推定量

線形推定量とは、推定量$\hat{\beta}$が、$Y_i$の線形関数として表されるものです。最小二乗法は、以下のように表され、線形推定量です。

$\hat\beta= \dfrac {\sum\limits_{i-1}^n (X_i-\bar{X})Y_i}{ \sum\limits_{i=1}^n(X_i-\bar{X})^2}$

$\hat\beta= \dfrac {1}{ \sum\limits_{i=1}^n(X_i-\bar{X})^2} \sum\limits_{i-1}^n (X_i-\bar{X})Y_i $

$\hat\beta= \dfrac {1}{ \sum\limits_{i=1}^n(X_i-\bar{X})^2} ((X_1-\bar{X})Y_1+(X_2-\bar{X}) Y_2 \dots (X_n-\bar{X})Y_n )$

これは以下のように書くことができます。

$\hat{\beta}=\sum\limits_{n=1}^n w_iY_i $

$w_i$は以下の式です。

$w_i=\dfrac { (X_i-\hat{X})}{ \sum\limits_{i=1}^n(X_i-\bar{X})^2}$

推定量$\hat{\beta}$が、$Y_i$の線形関数として表されることがわかります。

線形不偏推定量

まず不偏性があるために係数にどのような条件が必要かを考えて、最小二乗法がその条件を満たしていることを説明していきます。

線形推定量は一般に以下で表されます。

$ C=c_0+\sum\limits_{n=1}^n c_iY_i $

不偏性があるということはCの期待値$E(C)$が$\beta$になるということです。$\beta$を使った式にするため、$Y_i$に$\alpha+ \beta X_i$を代入します。

$\color{red}E(C) \color{black} =c_o+ \sum\limits_{i=1}^n c_i E(Y_i) $

$= c_0+ \sum\limits_{i=1}^n c_i(\alpha+ \beta X_i) $

$=c_0+\alpha \sum\limits_{i=1}^n c_i+ \beta \sum\limits_{i-1}^n c_i X_i$

Cの期待値$E(C)$が$\beta$になるためには、ウエートcに関して以下の条件が必要です。これが不偏性の条件になります。

$c_o=0 ,\sum\limits_{i=1}^n c_i =0, \sum\limits_{i=1}^n c_i X_i=1 $

この条件が満たされれば、Cの期待値$E(C)$が$\beta$になります。

$\color{red}E(C) =\beta \color{black} $

不偏性の条件

Cの期待値が$\beta$になるために、ウエートcに関して以下の条件が必要です。これが不偏性の条件になります。

$c_o=0 ,\sum\limits_{i=1}^n c_i =0, \sum\limits_{i=1}^n c_i X_i=1 $

最小二乗法の場合のウエートは以下で表されます。これが不偏性の条件を満たしているかどうかを一つ一つ見ていきます。

$\hat{\beta}=\sum\limits_{n=1}^n w_iY_i $

$ただし、w_i=\dfrac { (X_i-\bar{X})}{ \sum\limits_{i=1}^n(X_i-\bar{X})^2}$

最小二乗法が不偏性の条件を満たすためには以下の条件が必要です。$c_i$を$w_i$に変えただけです。

$c_o=0 ,\sum\limits_{i=1}^n w_i =0, \sum\limits_{i=1}^n w_i X_i=1 $

$c_0=0$について

$\hat{\beta}=\sum\limits_{n=1}^n w_iY_i $の式に定数項はないので、$c_0=0$は満たされています。

$ \sum\limits_{i=1}^n w_i=0$について

「ウエート$w_i$の総和がゼロ」は以下のように満たされています。

$ \sum\limits_{i=1}^n w_i= \dfrac {\sum\limits_{i=1}^n (X_i-\bar{X})}{ \sum\limits_{i=1}^n(X_i-\bar{X})^2}$

$ = \dfrac {\sum\limits_{i=1}^n X_i – \sum\limits_{i=1}^n \bar{X}}{ \sum\limits_{i=1}^n(X_i-\bar{X})^2}=0$

$ \sum\limits_{i=1}^n w_i X_i =1 $について

「ウエート$w_i$と$X_i$の積の総和は1」は以下の式の変形で証明できます。

$ \sum\limits_{i=1}^n w_i X_i= \dfrac {\sum\limits_{i=1}^n (X_i-\bar{X})X_i }{ \sum\limits_{i=1}^n(X_i-\bar{X})^2}$

$\color{red} \sum\limits_{i=1}^n (X_i – \bar{X})X_i= \sum\limits_{i=1}^n (X_i-\bar{X})^2 \color{black} $ という偏差に関する公式のうち「偏差の二乗和」を使うと、以下の式となります。

$ = \dfrac {\sum\limits_{i=1}^n (X_i-\bar{X})^2 }{ \sum\limits_{i=1}^n(X_i-\bar{X})^2}=1$

以上で、最小二乗法が不偏性を持つことが証明されました。

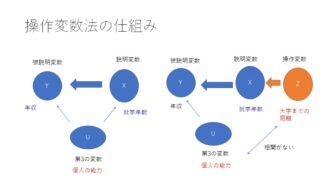

最良線形不偏推定量

最後に、線形不偏推定量の中で、最も分散が小さいことを証明します。最小二乗法のウエート以外の一般的な線形推定量を表すために、最小二乗法のウエート$w_i$に$d_i$を加えたウエート$c_i$を考えます。$c_i=w_i+d_i$です。$d_i$が非負になることが証明できれば、最小二乗法以外の線形推定量の分散は、最小二乗法より大きいことが証明できます。

まず、この一般的な線形推定量が不偏性を持つための条件を導きだします。

一般的な推定量の不偏性の条件

この推定量を変形していきます。最後の式には、$Y_i=\alpha+\beta X_i+u_i$を代入しています。

$ \tilde{\beta}= \sum\limits_{i=1}^n c_i Y_i $

$ =\sum\limits_{i=1}^n (w_i+d_i) Y_i $

$ = \sum\limits_{i=1}^n w_iY_i + \sum\limits_{i=1}^n d_i Y_i $

$= \sum\limits_{i=1}^n w_i \alpha + \sum\limits_{i=1}^n w_i \beta X_i +\sum\limits_{i=1}^n + w_i u_i \sum\limits_{i=1}^n +d_i \alpha +\sum\limits_{i=1}^n d_i \beta X_i + \sum\limits_{i=1}^n d_i u_i $

不偏性の項で調べたように、最小二乗法のウエート$w_i$には以下の性質があります。

- $ \sum\limits_{i=1}^n w_i=0$

- $ \sum\limits_{i=1}^n w_i X_i =1 $

これを使うと上記式の第1項と第2項は以下のようになります。

$ \sum w_i \alpha = \alpha \sum w_i=0 $

$ \sum w_i\beta X_i=\beta \sum w_i X_i=\beta$

これを反映すると以下の式になります。

$ \tilde{\beta}= \beta +\sum\limits_{i=1}^n w_i u_i +\sum\limits_{i=1}^n d_i \alpha +\sum\limits_{i=1}^n d_i \beta X_i + \sum\limits_{i=1}^n d_i u_i $

期待値をとると、誤差項の平均はゼロなので、$E(u_i)$=0になります。

$E(\tilde{\beta}) =E\left[\beta +\sum\limits_{i=1}^n w_i u_i +\sum\limits_{i=1}^n d_i \alpha +\sum\limits_{i=1}^n d_i \beta X_i + \sum\limits_{i=1}^n d_i u_i \right]$

$ =\beta + \sum\limits_{i=1}^n d_i \alpha +\sum\limits_{i=1}^n d_i \beta X_i $

$ = \beta + \alpha \sum\limits_{i=1}^n d_i +\beta \sum\limits_{i=1}^n d_i X_i $

そしてこれが不偏推定量になるためには、上の式が$\beta$になる必要があるので、$di$に制約が加わります。

$d_i$に関する不偏性の条件は、$ \sum\limits_{i=1}^n d_i=0, \sum\limits_{i=1}^n d_i X_i=0$です。

線形不偏推定量の分散

線形不偏推定量の一般形について、以下の形から出発します。上記で考えたのは、線形推定量でしたが、今回は線形不偏推定量なので、$\check{\beta}$と記号を変えました。

$ \check{\beta}= \sum\limits_{i=1}^n c_i Y_i $

$ =\sum\limits_{i=1}^n (w_i+d_i) Y_i$

これを変形すると、以下の形になりました(上記不偏性の条件参照)。

$ \check{\beta}= \beta +\sum\limits_{i=1}^n w_i u_i +\sum\limits_{i=1}^n d_i \alpha +\sum\limits_{i=1}^n d_i \beta X_i + \sum\limits_{i=1}^n d_i u_i $

不偏性の条件である、$ \sum\limits_{i=1}^n d_i=0, \sum\limits_{i=1}^n d_i X_i=0$を代入すると、より簡単な式になります。

$ \check{\beta}= \beta +\sum\limits_{i=1}^n w_i u_i + \sum\limits_{i=1}^n d_i u_i $

この推定量の分散を求めます。最後の式の変形には$\color{red} ( \sum\limits_{i=1}^{n} X_i )^2=\sum\limits_{i=1}^n \sum\limits_{j=1}^n X_{i}X_j \color{black} $ という2重和の公式を使っています。

$ \sigma^2_{\check{\beta}}=E( \check{\beta}- \beta)^2$

$=E\left[\beta +\sum\limits_{i=1}^n w_i u_i + \sum\limits_{i=1}^n d_i u_i-\beta\right]^2 $

$=E[\sum (w_i + d_i )u_i ]^2 $

$ =E[ \sum\limits_{i=1}^n (w_i+d_i)^2 u_i^2+ \sum\sum\limits_{i \neq j} (w_i+d_i)(w_j+d_j)u_iu_j ]$

誤差項に$E(u_i u_j)$=0($i \neq j$ について)を仮定すると、第2項は0になります。

$ =E[ \sum\limits_{i=1}^n (w_i+d_i)^2 u_i^2 ]$

$E(u_i^2)$は常に$\sigma^2$なので、かっこの前に出すことができます。

$=E[ \sum\limits_{i=1}^n (w_i+d_i)^2 u_i^2 ]$

$=E(u_i^2) \sum\limits_{i=1}^n (w_i+d_i)^2 $

$=\sigma^2(\sum\limits_{i=1}^n w_i^2+ 2 \sum\limits_{i=1}^n w_i d_i + \sum\limits_{i=1}^n d_i^2 ) $

$\sum w_i^2$ について

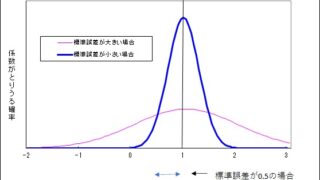

ウエート$w_i$の二乗和に$\sigma^2$は、最小二乗法の誤差項の分散になります。

$\sum w_i^2 = \sum \left( \dfrac{X_i-\bar{X}}{\sum( X_i-\bar{X} )^2} \right)^2 $

$= \dfrac{\sum(X_i-\bar{X} )^2}{(\sum(X_i- \bar{X} )^2 )^2} $

$ = \dfrac {1}{\sum\limits_{i=1}^n (X_i-\bar{X} )^2}$

$ \sigma^2 \sum w_i^2= \dfrac{\sigma^2}{\sum(X_i-\bar{X})^2}=\sigma^2_{\hat{\beta}}$

$\sum w_i d_i $について

この項は、不偏性の条件である$\sum d_i=0, d_i X_i=0$を使うとゼロになることがわかります。

$ \sum d_iw_i=\sum d_i \left(\dfrac{(x_i-\hat{X})}{\sum(X_i-\hat{X})^2} \right) $

$ = \dfrac{\sum d_iX_i – \bar{X} \sum d_i }{\sum(X_i – \bar{X})^2}=0$

最終的な分散の式

$ \sigma^2_{\check{\beta}}=\sigma^2_{\hat{\beta}} + \sigma^2 \sum d_i^2 $

$\sum d^2_i $は負にならないので、一般的な線形不偏推定量の分散は、最小二乗法の推定量の分散と等しいか、大きいということなります。このことから、最小二乗法の推定量の分散が最も小さいということが証明されました。