単回帰分析の回帰係数βは誤差の二乗を最小化することで得られます。

その導出も大事ですが、この記事ではその先の期待値や分散の導出方法について解説します。

まず、最初に結論としての式を書きます。その後にできるだけわかりやすく、解説をつけていきます。

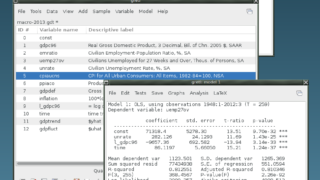

経済統計の使い方では、統計データの入手法から分析法まで解説しています。

回帰係数β

まず結果を見ます。

$ \hat{\beta}=\dfrac{\sum\limits_{i=1}^n(X_i-\bar{X})(Y_i-\bar{Y})}{\sum\limits_{i=1}^n (X_i-\bar{X})^2} =\dfrac{\sum\limits_{i=1}^n(X_i-\bar{X})Y_i}{\sum\limits_{i=1}^n (X_i-\bar{X})^2}$

βの確率的表現

まず結果を見ます。係数を誤差項の関数として表したものです。

$\hat{\beta}=\beta+ \dfrac{\sum\limits_{n=1}^n (X_i- \bar{X})u_i}{\sum\limits_{n=1}^n (X_i-\bar{X})^2}$

βの期待値

$E(\hat{\beta})=\beta+ \dfrac{\sum\limits_{n-1}^n (X_i- \bar{X})E(u_i)}{\sum\limits_{n-1}^n (X_i-\bar{X})^2}$

最小二乗法の仮定により、「$u_i$の期待値はゼロ」なので、以下の結果になります。

$E(\hat{\beta})=\beta$

βの分散

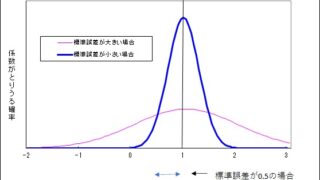

まず結果を見ます。$\sigma$は誤差項の分散です。

$V(\hat{\beta})=\dfrac{\sigma^2}{\sum\limits_{n-1}^n (X_i-\bar{X})^2}$

回帰係数βの変形

$ \hat{\beta}=\dfrac{\sum\limits_{i=1}^n(X_i-\bar{X})(Y_i-\bar{Y})}{\sum\limits_{i=1}^n (X_i-\bar{X})^2} $

$ =\dfrac{\sum\limits_{i=1}^n(X_i-\bar{X})Y_i- \bar{Y}\sum\limits_{i=1}^n(X_i-\bar{X})}{\sum\limits_{i=1}^n (X_i-\bar{X})^2} $

$X_i$を1からnまで足したものと、平均$\bar{X}$をn回足したものは同じなので、$\sum\limits_{i=1}^n(X_i-\bar{X})=0$。

$ =\dfrac{\sum\limits_{i=1}^n(X_i-\bar{X})Y_i}{\sum\limits_{i=1}^n (X_i-\bar{X})^2}$

βの確率的表現

$Y_i=\alpha + \beta X_i +u_i$

この式は平均についても成り立つので、以下の式が成り立ちます。

$ \bar{Y}=\alpha + \beta \bar{X} + \bar{u} $

基本の式から平均の式を引くと、以下の式になります。

$Y_i- \bar{Y_i} = \beta (X_i-\bar{X}) +u_i- \bar{u} $

$\hat{\beta}$は以下のように表せます。

$ \hat{\beta}=\dfrac{\sum\limits_{i=1}^n(X_i-\bar{X})(\beta (X_i-\bar{X}) +(u_i- \bar{u} ))}{\sum\limits_{i=1}^n (X_i-\bar{X})^2} $

$ =\beta \dfrac{\sum\limits_{i=1}^n(X_i-\bar{X}) ^2}{\sum\limits_{i=1}^n (X_i-\bar{X})^2}+ \dfrac{\sum\limits_{i=1}^n (X_i-\bar{X})(u_i- \bar{u} )}{\sum\limits_{i=1}^n (X_i-\bar{X})^2} $

$ =\beta + \dfrac{\sum\limits_{i=1}^n (X_i-\bar{X})u_i }{\sum\limits_{i=1}^n (X_i-\bar{X})^2} -\dfrac{\sum\limits_{i=1}^n (X_i-\bar{X})\bar{u} }{\sum\limits_{i=1}^n (X_i-\bar{X})^2}$

$\sum\limits_{i=1}^n (X_i-\bar{X})\bar{u}=(X_i-\bar{X})\sum\limits_{i=1}^n \bar{u} $で、$\sum\limits_{i=1}^n \bar{u} $は「誤差の平均はゼロ」なので、全体としてもゼロです。

βの期待値の変形

$E(\hat{\beta})=\beta+ \dfrac{\sum (X_i- \bar{X})E(u_i)}{\sum(X_i-\bar{X})^2}$

$=\beta+ E(u_i) \dfrac{\sum (X_i- \bar{X})}{\sum(X_i-\bar{X})^2}$

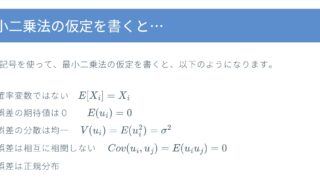

最小二乗法の仮定により「$u_i$の期待値はゼロ」なので、$E(u_i)=0$になります。

$=\beta$

期待値がβになるために使った仮定は「$X_i$や$\hat{X}$は非確率変数」「$u_i$の期待値はゼロ」なので、不均一分散がある場合でも、この式は成り立ちます。

βの分散の変形

分散は、変数の平均からの偏差の二乗の平均なので、$V(X)=E((X-E(X))^2)$となります。$\hat{\beta}$は$\beta$の不偏推定量なので、$\hat{\beta}$の平均(期待値)は$\beta$になります。これらを勘案すると以下の変形ができます。

$V(\hat{\beta})=E (\hat{\beta}-E(\hat{\beta}))^2=E(\hat{\beta}-\beta)^2 $

$\hat{\beta}$に$\beta$の期待値の式を代入します。

$=E \left[ \left( \beta+ \dfrac{\sum\limits_{i=1}^n (X_i- \bar{X})u_i}{\sum\limits_{i=1}^n (X_i-\bar{X})^2}-\beta \right)^2 \right] $

$=E \left[ \left( \dfrac{\sum\limits_{i=1}^n (X_i- \bar{X})u_i}{\sum\limits_{i=1}^n (X_i-\bar{X})^2} \right) ^2 \right] $

$=\dfrac{E \lbrack (\sum\limits_{i=1}^n (X_i- \bar{X})u_i)^2 \rbrack }{E \lbrack (\sum\limits_{i=1}^n (X_i-\bar{X})^2)^2 \rbrack }$

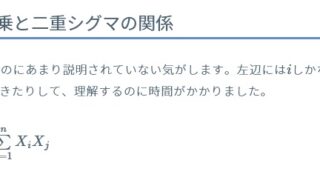

$ (\sum\limits_{i=1}^n (X_i- \bar{X})u_i) ^2 $ に対して、$\color{red} ( \sum\limits_{i=1}^{n} X_i )^2=\sum\limits_{i=1}^n \sum\limits_{j=1}^n X_{i}X_j \color{black} $ を使います。

$\dfrac{1}{(\sum(X_i-\hat{X})^2)^2} E \lbrack \sum\limits_{i=1}^n \sum\limits_{j=1}^n (X_i-\hat{X})u_i(X_j-\hat{X})u_j \rbrack $

$=\dfrac{1}{(\sum(X_i-\hat{X})^2)^2} E \lbrack \sum\limits_{i=1}^n \sum\limits_{j=1}^n u_iu_j (X_i-\hat{X})(X_j-\hat{X}) \rbrack $

$= \dfrac{1}{(\sum(X_i-\bar{X})^2)^2} \sum (X_i-\bar{X})^2 \sigma^2 $

$= \dfrac{1}{(\sum(X_i-\bar{X})^2)^2} \sigma^2 \sum (X_i-\bar{X})^2 $

$= \dfrac{\sigma^2}{\sum(X_i-\bar{X})^2} $

分子の変形について

上記の変形について、詳しく見ていきます。分子の部分は以下の式に期待値をとったものです。2つの部分に分けて期待値をとります。

$\sum\limits_{i=1}^n \sum\limits_{j=1}^n u_iu_j(X_i-\hat{X})(X_j-\hat{X}) $

$=\sum\limits_{i=j} (X_i-\bar{X})^2 u_i^2 +\sum\limits _{i \neq j} (X_i-\bar{X})(X_j-\bar{X}) E(u_i)E(u_j) $

第1項の期待値

第1項は、iとjが等しい場合で、1からnまでn個あります。

第1項について期待値をとります。「$X_i$と$\bar{X}$は非確率変数」という最小二乗法の仮定から、前半の期待値オぺーレーターを取ることができます。誤差項の二乗の期待値は、誤差項の分散に等しく、$E(u_i^2)=\sigma^2$です。

$ E(\sum\limits_{i=1}^n (X_i-\bar{X})^2 u_i^2) $

$ =\sum\limits_{i=1}^n (X_i-\bar{X})^2 E(u_i^2) $

$ =\sum\limits_{i=1}^n (X_i-\bar{X})^2 \sigma^2 $

第2項の期待値

次に、第2項について期待値をとります。「$X_i$と$\bar{X}$は非確率変数」という最小二乗法の仮定から、前半の期待値オぺーレーターを取ることができます。

$E \left[ \sum\limits _{i \neq j} (X_i-\bar{X})(X_j-\bar{X}) u_iu_j \right]$

$ =\sum\limits _{i \neq j} (X_i-\bar{X})(X_j-\bar{X})E( u_i u_j) $

「異なる誤差どうしは無相関」という最小二乗法の仮定から、$E(u_i u_j)=0$になります。

$ \sum\limits _{i \neq j} (X_i-\bar{X})(X_j-\bar{X})E( u_i u_j)=0 $

再掲

まとめると以下の式です。

$E(\sum\limits_{i=1}^n \sum\limits_{j=1}^n u_i u_j(X_i-\hat{X})(X_j-\hat{X}))$

$ =\sum\limits_{i=1}^n (X_i-\bar{X})^2 \sigma^2 $

これを元の式から順に書くと以下の通りになります。

$\dfrac{1}{(\sum(X_i-\hat{X})^2)^2} E \lbrack \sum\limits_{i=1}^n \sum\limits_{j=1}^n u_iu_j(X_i-\hat{X})(X_j-\hat{X}) \rbrack $

$= \dfrac{1}{(\sum(X_i-\bar{X})^2)^2} \sum (X_i-\bar{X})^2 \sigma^2 $

$= \dfrac{1}{(\sum(X_i-\bar{X})^2)^2} \sigma^2 \sum (X_i-\bar{X})^2 $

$= \dfrac{\sigma^2}{\sum(X_i-\bar{X})^2} $

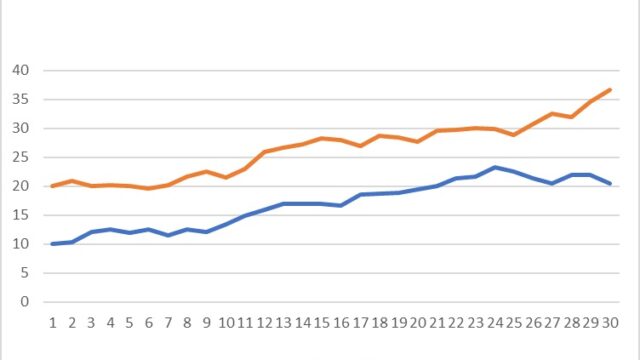

- 【時系列分析】課題3 ドリフト付きランダムウォーク

- 【時系列分析】課題2 グレンジャーの因果関係

- 【時系列分析】課題1 為替レートの予測

- 「回帰分析から学ぶ計量経済学」を使ったセミナーを行います(2024年3月8日)

- 正誤表 回帰分析から学ぶ計量経済学